Les essais de toxicologie visent à déterminer les propriétés toxiques intrinsèques des substances chimiques. La règlementation impose de déterminer les effets sur la santé humaine et les effets sur l’environnement. Nous ne nous occuperons que des effets sur la santé humaine, lesquels sont largement évalués selon les normes actuelles… sur des animaux !

Les résultats des tests de toxicologie sont utilisés par les autorités pour évaluer un danger et un risque. Le danger que représente une substance donnée résulte de ses propriétés toxiques intrinsèques. Le risque résulte à la fois de ces propriétés et des conditions dans lesquelles nous pouvons y être exposés. Par exemple, un intermédiaire de synthèse (substance produite lors du processus industriel de transformation ou d’extraction d’une autre substance) qui serait très toxique, donc très dangereux, ne représente pas un risque important pour la population s’il ne sort jamais du laboratoire. Par contre, il peut représenter un risque pour des travailleurs qui y seraient exposés. Si le risque est reconnu et que la substance est tout de même jugée nécessaire à la société, elle peut être autorisée si le fabricant prouve qu’il est possible de prendre les mesures nécessaires de maîtrise du risque (masques, gants, tenues spéciales, ventilation, etc.).

Quelques rappels sur la règlementation en toxicologie

La décision règlementaire d’autorisation de commercialisation d’une substance chimique est une opération complexe. Parmi les éléments sur lesquels elle se fonde, figurent les tests de toxicité pour l’homme, sujet de cet article. Pour pouvoir être pris en compte à des fins de décision réglementaire, ces tests doivent avoir été validés (par un organisme de référence, ECVAM en Europe) et avoir reçu une acceptation réglementaire (les « lignes directrices » de l’OCDE recensent les tests reconnus à l’échelle internationale). Les protocoles de ces tests sont ainsi définis très précisément et appliqués partout dans le monde. Nous faisons deux critiques principales à ce système : 1) le processus de validation et d’acceptation réglementaire étant trop long (jusqu’à une quinzaine d’années), des méthodes parmi les plus modernes, valables scientifiquement, ne sont pas utilisées à des fins règlementaires ou peuvent l’être en complément et non comme source d’information principale ; 2) la validation d’une nouvelle méthode d’essai se fait par comparaison avec les résultats obtenus lors d’essais sur des animaux, alors que les essais sur des animaux n’ont jamais été validés par comparaison avec les données humaines !

La science et la technologie progressant de plus en plus vite, il existe un grand décalage entre les méthodes et les concepts valables du point de vue scientifique et ceux pris en compte par la règlementation. Pour compliquer le tout, certaines règlementations sont en contradiction avec d’autres : les tests imposés pour déterminer la toxicité d’une substance chimique ne sont pas les mêmes selon que cette substance soit un cosmétique, un pesticide, une substance industrielle ou un médicament. Il est interdit de tester un cosmétique sur des animaux alors qu’un médicament doit obligatoirement avoir été testé sur au moins deux espèces animales. Pourtant, les substances que nous appliquons sur la peau peuvent toutes pénétrer dans le corps. Voir, par exemple, les études de P. Darbre qui a trouvé des parabènes (substances contenues dans certains déodorants) dans des biopsies de tumeurs aux seins (Journal of Applied Toxicology, 2004, vol 24, pp 167-76).

Les essais de médicaments destinés à l’homme

Des essais précliniques peuvent se faire in vitro mais doivent aussi inclure des essais sur au moins deux espèces de mammifères dont un non rongeur. Le plus souvent, ces tests se font sur le rat ou la souris (rongeurs) et sur le chien ou le singe (non rongeurs).

Les essais cliniques se déroulent ensuite sur des sujets humains, en 4 phases :

– phase I : sur un petit groupe (une dizaine) d’individus sains afin de déterminer la tolérance du médicament ; d’après l’Institut national de la santé (NIH) états-unien, plus de 30% des médicaments prometteurs chez l’animal échouent aux essais cliniques en raison de toxicité non détectée chez les animaux.

– phase II : sur un petit groupe (une centaine) de patients afin de déterminer la dose efficace.

– phase III : sur un groupe important (plusieurs centaines à milliers) de patients afin de déterminer l’efficacité du nouveau médicament par rapport à un placebo ou par rapport à un médicament existant. Toujours d’après le NIH, 60% des médicaments prometteurs chez l’animal échouent aux essais cliniques par manque d’efficacité. L’incertitude dans la détermination de la toxicité et de l’efficacité sur l’animal est en partie due à des différences d’enzymes métabolisant les médicaments entre différentes espèces et à une sensibilité spécifique des types cellulaires aux substances toxiques (ALTEX Proceedings, Prague 2014, V-1-229).

– phase IV, dite de « pharmacovigilance » : surveillance des effets secondaires constatés chez des patients une fois que le médicament a été approuvé. Cette phase n’est pas à proprement parler un essai clinique puisque le médicament est prescrit en conditions réelles à toute la population de patients. C’est pourtant à ce stade que des effets secondaires graves, voire mortels, peuvent être constatés, menant aux scandales que l’on connaît (staltor, mediator, etc.).

Pour les substances à usage industriel (incluant colles, solvants, retardateurs de flammes et autres substances que l’on peut trouver dans nos maisons), les tests sur des animaux sont imposés selon la quantité de substance produite ou importée par an. REACH est le nom de la règlementation européenne qui régit cette catégorie de substances. Des tests sur des animaux peuvent aussi être faits pour des additifs alimentaires (non concernés par REACH) ou pour des pesticides, le plus souvent sur des rongeurs.

Un bébé qui vient au monde aujourd’hui a plus de 200 substances chimiques dans le sang. Que sait-on sur la toxicité de ces substances et sur leurs possibles effets sur la santé de cet individu tout au long de sa vie ? Pas grand chose. L’Organisation mondiale de la santé (OMS) dresse une liste de substances qu’elle qualifie de cancérigènes « avérés » pour l’animal mais seulement « possibles » ou « probables » pour l’homme. A quoi ont donc servi les tests sur des animaux ? Dans son livre « Notre poison quotidien », la journaliste d’investigation Marie-Monique Robin montre comment les calculs de « dose journalière admissible » (DJA) faits à partir d’études sur des animaux, ne reposent sur aucun critère scientifique. Thalidomide, distilbène, mediator, etc., les exemples sont nombreux de médicaments testés avec succès sur des animaux et ayant gravement handicapé, rendu malade ou même tué des humains. Aspirine, pénicilline, deux exemples de médicaments utiles pour l’homme et capables de tuer ou de handicaper d’autres mammifères.

Des méthodes scientifiques dépassées

Les tests de toxicité effectués sur des animaux ne permettent pas de prédire les réactions d’un organisme humain face à une substance donnée. C’est un fait scientifique établi, que des règlementations obsolètes n’ont pas encore pris en compte.

Ces règlementations se basent sur une liste de toxicités à évaluer et imposent une liste de tests (avec ou sans animaux) à effectuer pour chaque type de toxicité. Pour se conformer au principe des 3R (qui ne relève pas d’un concept scientifique et accepte la prétendue validité du « modèle animal »), la règlementation vise à remplacer les tests sur des animaux par des « méthodes alternatives » validées.

Mais certaines de ces méthodes « alternatives » (c’est le terme consacré par les autorités) sont en fait des alternatives à l’utilisation d’animaux vivants mais utilisent des cellules ou tissus animaux. Pour l’irritation oculaire, par exemple, les méthodes validées et acceptées sont « l’essai d’opacité et de perméabilité de la cornée bovine » (OCDE, LD 437, 26/6/2013) et « l’essai sur oeil de poulet isolé » (OCDE, LD 438, 26/6/2013). Pourtant, EpiOcularTM est un test d’irritation oculaire in vitro qui utilise du tissu humain et remplit les critères pour être validé (ALTEX Proceedings, Prague 2014, II-4-398).

Quand on parle des « méthodes alternatives » à l’expérimentation animale, il faut donc se mettre d’accord sur le sens qu’on donne à cette expression. Pour les autorités, il s’agit de méthodes validées permettant de réduire, rationaliser ou remplacer (3R) l’utilisation d’animaux vivants.

Pour nous, il serait temps d’arrêter ce bricolage et d’instaurer l’utilisation de méthodes basées sur du matériel humain (cellules, tissus, données cliniques…). Il faut cesser de procéder au remplacement méthode par méthode et raisonner en termes de stratégie globale d’évaluation de la toxicité des centaines de milliers de substances actuellement fabriquées dans le monde. On ne peut plus se permettre de les tester une par une sur des animaux (ça prend au moins deux ans pour chaque substance) ni même par des méthodes qui ne mettent en évidence qu’un seul type d’effet à la fois.

Avec l’entrée en vigueur de REACH (le 1er juin 2007), la toxicologie a changé d’échelle. Le nombre de substances à tester est subitement passé à plusieurs dizaines de milliers. La nouvelle approche devrait donc commencer par un « criblage à haut débit » (méthodes qui répondent à la question : parmi des centaines ou des milliers de substances, lesquelles sont les plus dangereuses ?). Elle devrait se poursuivre par des études de plus en plus précises pour les substances pour lesquelles les premiers résultats ne sont pas concluants ou auxquelles notre risque d’exposition est le plus fort. Une telle approche a été proposée aux Etats-Unis dans le rapport du Conseil national de la recherche intitulé « Tests de toxicité au 21ème siècle : une vision et une stratégie ». Plusieurs articles ont été consacrés à ce sujet dans La Notice d’Antidote depuis 2007, année de publication du rapport.

Ce rapport a été suivi d’actions concrètes aux Etats-Unis. Par exemple, le consortium Tox21 est en train de passer au crible 10 000 substances sur des voies de toxicité (nous reviendrons sur ce concept) en utilisant une approche de criblage à haut débit quantitative. Plus de 48 millions de données brutes ont été générées à partir d’environ 30 tests. La fiabilité du système est évaluée en tripliquant les tests et en analysant la reproductibilité des résultats. Le système robotique de Tox21, combiné à des moyens informatiques, est capable de passer au crible 10 000 substances, en tripliquant les tests… en une semaine ! (ALTEX Proceedings, Prague 2014, I-2-91, II-3-546, II-6a-930) Reste à savoir quoi faire de cette avalanche de données ! Ce n’est pas résolu, surtout du point de vue règlementaire mais cet exemple illustre la puissance des moyens modernes alors que l’on continue à empoisonner des lots d’animaux dont on observe l’agonie pendant des périodes pouvant aller jusqu’à deux ans (essais de carcinogénicité). Des analyses des données issues de Tox21 ont déjà mis en évidence la supériorité des méthodes in vitro sur du matériel humain par rapport aux données animales pour prédire la toxicité pour l’homme. L’un des problèmes qui se posent aux toxicologues pour améliorer ces méthodes est le manque de données de toxicité pour l’homme pour les différentes substances étudiées. En comparant les données issues des tests sur cellules humaines et les données issues de tests sur des animaux, ils s’aperçoivent que la corrélation n’est pas bonne (Huang R et al, Nature Communications, 26 janvier 2016). Ce qui confirme, une fois de plus, que les tests sur des animaux ne permettent pas de prédire la toxicité pour l’homme d’une substance donnée. Pour valider les méthodes in vitro proposées par Tox21 et d’autres sources, il faudra donc construire des bases de données sur la toxicité des substances pour l’homme (par exemple à partir d’essais cliniques de médicaments) afin de pouvoir déterminer quels sont les tests in vitro qui fournissent les données les plus concordantes avec la toxicité réelle observée sur l’homme.

Selon les normes actuelles (REACH), les principales caractéristiques toxiques qui doivent être évaluées pour chaque substance chimique sont :

– la toxicité aiguë (une seule dose) ou chronique (exposition répétée ou prolongée) d’une substance administrée à des animaux par voie orale, par inhalation, par application sur la peau. Des rats ou des souris sont utilisés la plupart du temps. Les études durent en général 28 jours ou 90 jours.

– l’irritation et la corrosion (lésions irréversibles) de la peau. Le lapin albinos était le plus souvent utilisé mais il existe à présent des méthodes validées sur peau humaine reconstituée.

– l’irritation oculaire. Des essais sur oeil de boeuf ou de poulet ont été validés en remplacement du test sur lapins vivants.

– la sensibilisation cutanée (allergie par contact avec la substance testée). La méthode de référence actuelle utilise des souris vivantes, en remplacement d’un test sur cobayes. Pourtant, des méthodes sur tissus humains sont disponibles (nous verrons ceci plus en détail).

– la toxicité génétique. Des rats ou des souris transgéniques sont utilisés pour cette évaluation.

– la toxicité pour la reproduction et le développement prénatal. Souris, rats ou lapins étudiés sur une génération.

– la carcinogénicité.

Les lignes directrices de l’OCDE pour les essais de produits chimiques « est une collection d’environ 100 des plus pertinents tests reconnus à l’échelle internationale et méthodes d’essai utilisées par les gouvernements, l’industrie et des laboratoires indépendants afin d’identifier et de définir les dangers potentiels des nouvelles substances chimiques, préparations chimiques et mélanges chimiques. » Outre les applications mentionnées ci-dessus pour le règlement REACH (substances chimiques industrielles), d’autres tests concernent la toxicocinétique (important pour les médicaments), la neurotoxicité ou la perturbation du système endocrinien, toujours sur des animaux…

Nous pourrions citer d’innombrables articles montrant que la détermination de la toxicité pour les animaux ne permet pas de prédire la toxicité pour l’homme. Ce n’est pas notre objet ici. Mais nous vous proposons deux extraits de déclarations du Centre commun de recherche (JRC, Commission européenne) et du Centre national britannique pour le remplacement, la rationalisation et la réduction des animaux dans la recherche (NC3Rs) montrant sur quelles incertitudes se fondent des règlementations pourtant censées nous protéger :

« L’évaluation de la toxicité aiguë systémique est requise par plusieurs règlementations européennes. Actuellement, seuls des tests in vivo [sur des animaux] sont acceptés par les autorités de règlementation. Les essais de cytotoxicité [sur cellules] sont simplement reconnus comme tests supplémentaires pour estimer la dose initiale pour les essais in vivo. » (JRC, ALTEX Proceedings, Prague 2014, IX-3-293) A méditer à la lumière de cette autre information : « La capacité des tests sur des animaux à prédire la toxicité pour l’homme a été estimée à environ 50%, et même à environ 20%. » Dès 1983, le Dr Björn Ekwall formulait le « concept de cytotoxicité basale », lequel s’accorde assez bien avec la vision globale actuelle selon laquelle les tests de toxicité devraient se fonder sur l’évaluation d’effets sur des événements moléculaires clés au sein de voies cellulaires essentielles en utilisant des cellules, tissus et modèles d’organes humains (ALTEX Proceedings, Prague 2014, X-3-572).

Mais, en 2015 encore, « des études de toxicité à court terme sont faites sur des animaux pour fournir des informations sur les principaux effets néfastes surtout à la dose maximale tolérée. Ces études sont utilisées pour prendre des décisions pour progresser dans le développement du médicament et pour établir des doses pour les études ultérieures pour se conformer à la règlementation. La dose maximale tolérée est habituellement déterminée en fonction de signes cliniques, de perte de poids ou de consommation de nourriture. Toutefois, ces estimations sont subjectives et il n’existe pas de critères publiés pour aider à la détermination correcte de la dose maximale tolérée. Même lorsqu’une mesure objective existe, comme pour la perte de poids corporel, il n’y a pas de consensus sur le niveau qui constituerait la dose maximale tolérée. » Des chercheurs du NC3Rs proposent de retenir comme critère une réduction du poids corporel de 10% chez le rat et de 6% chez les primates non humains (ALTEX Proceedings, Prague 2014, VIII-2b-684). Et à quelle dose on commence un essai sur l’homme ?

De nouveaux concepts

La détermination des caractéristiques physico-chimiques d’une substance (acidité, réactivité, affinité pour d’autres molécules, etc.) se fait en dehors de tout environnement biologique. Or, connaître la structure chimique précise d’une nouvelle molécule permet de calculer sa toxicité par comparaison avec celle d’une molécule similaire. C’est le champ des méthodes dites de SARs (relation entre structure et activité). Par exemple, le bisphénol A a une structure similaire à celle du distilbène, médicament connu pour avoir provoqué des cancers et autres maladies chez les filles et petites-filles de femmes l’ayant pris pendant leur grossesse. Sans surprise, plusieurs études ont montré le potentiel cancérigène du bisphénol A et ses autres propriétés de perturbateur endocrinien.

Les diverses fonctions biologiques, au sein d’une cellule, s’effectuent par des réactions biologiques en cascade, faisant intervenir des enzymes et autres molécules bien déterminées. Une substance chimique étrangère à l’organisme peut altérer des voies biologiques normales ou provoquer des réactions néfastes. Au niveau de la cellule, ceci pourra se traduire par un dysfonctionnement (par exemple, suite à l’accumulation de protéines défectueuses), voire la mort de la cellule si celle-ci ne parvient pas à réparer les dégâts. Au niveau de l’organisme, ces dysfonctionnements ou pertes cellulaires pourront se traduire par différentes maladies (cancer, neuropathologies, etc.).

La toxicologie moderne s’oriente vers la caractérisation de voies toxicologiques impliquées dans des effets indésirables. Plusieurs termes désignent des variantes de ce concept : voie source à effet, voie de toxicité, mode d’action, voie impliquée dans des effets indésirables. Nous retiendrons le sigle anglais AOP (pour Adverse Outcome Pathway), déjà utilisé dans des publications de référence en français. « Bien que cette terminologie ne soit pas harmonisée, ces expressions sont toutes basées sur le présupposé qu’une substance toxique, après avoir atteint et interagi avec une cible biologique, va déclencher une cascade d’événements qui peuvent mener à un état néfaste, au niveau de l’organisme ou de la population. L’hypothèse générale de l’approche AOP est qu’un ensemble limité d’événements clés mesurables suffit à décrire les voies biologiques et à prédire des effets néfastes à différents niveaux d’organisation (cellule, tissu/organe, organisme, population). » (Deuxième rapport de l’Agence européenne des substances chimiques (ECHA) sur l’utilisation des méthodes alternatives aux tests sur des animaux pour le règlement REACH, 2014)

Pour mettre en évidence ces événements clés, il peut être nécessaire de recourir à plusieurs tests, alors que selon la toxicologie classique, un seul test sur des animaux donnait la réponse pour une propriété toxique donnée. Un autre concept nouveau est celui de stratégie d’analyses intégrées ou d’approches intégrées en matière d’essais et d’évaluation. Désignées par les sigles anglais ITS ou IATA, ces deux expressions sont équivalentes. Elles marquent une autre révolution en matière de toxicologie règlementaire : on ne fait pas un nouveau test si on a déjà l’information par ailleurs et on peut utiliser toutes les sources possibles d’information. Certaines méthodes alternatives sont considérées comme insuffisantes par elles-mêmes mais peuvent être utilisées dans le cadre d’une ITS qui permettra, elle, de prendre la décision règlementaire.

La directive Cosmétiques interdisant de tester ces produits sur des animaux, les fabricants ont redoublé d’efforts pour mettre au point de nouvelles méthodes et stratégies. Par exemple, L’Oréal a mis au point un modèle pour remplacer la DL50, mesure standard de la toxicité orale aiguë sur des animaux. Le modèle peut classer des produits par niveaux de toxicité, identifier des mécanismes d’action et estimer la toxicité aiguë. « Cette étude démontre qu’une façon d’évaluer la toxicité aiguë systémique a été de combiner de multiples paramètres déduits des mécanismes d’action des substances et certaines propriétés chimiques clés » (ALTEX Proceedings, Prague 2014, II-11-819).

La première étape d’une ITS consisterait à collecter toutes les données déjà existantes sur les différentes substances enregistrées. Il s’agit de ce que l’on nomme les « études sans tests ». Pour un certain nombre de substances, ces données seraient déjà concluantes. Les intoxications humaines, volontaires ou accidentelles, sont nombreuses. A l’heure où des agriculteurs voient leur cancer ou maladie neurologique reconnus en maladie professionnelle, faut-il vraiment consacrer beaucoup de temps et d’argent pour accumuler de nouvelles preuves de la toxicité des pesticides pour l’homme ?

On peut ensuite appliquer la méthode des catégories et la méthode des références croisées. La première consiste à classer une substance chimique dans une catégorie de substances similaires pour lesquelles la toxicité est déjà connue. La seconde consiste à évaluer la toxicité de la nouvelle substance grâce aux données de toxicité disponibles pour les substances de même catégorie. Ces deux méthodes sont déjà largement utilisées par les industriels pour se conformer au règlement REACH. Elles ont permis de faire moins de tests sur des animaux que ce qui avait été estimé avant l’entrée en vigueur de REACH.

Nous sommes tout à fait favorables à ces études sans test, que ce soit par SARs, par la méthode des références croisées ou toute autre méthode pertinente. Mais attention ! Ces méthodes informatiques requièrent la compilation de données de toxicologie obtenues par des méthodes expérimentales. Or, pour être fiables pour l’homme, ces données ne devraient concerner que l’espèce humaine. Pour reprendre l’exemple du bisphénol A et du distilbène, on peut appliquer la méthode des références croisées et déduire la toxicité du bisphénol A de celle du distilbène uniquement parce que l’on connaît la toxicité du distilbène pour l’homme. Malheureusement, cette connaissance a été acquise au prix de la tragédie de nombreuses victimes. Les centres anti-poison devraient être mis à contribution dans la constitution des bases de données, de même que les laboratoires pharmaceutiques en fournissant les données de tous leurs essais cliniques, même négatifs. Le danger que nous voyons dans ces méthodes est que les autorités sont prêtes à prendre en compte aussi bien des données animales. Par exemple, pour la détermination de la carcinogénicité d’une nouvelle substance, si le fabriquant trouve des données de cancérogénicité obtenues par des tests sur des animaux pour une substance de même catégorie, il pourra utiliser la méthode des références croisées et éviter de faire un nouveau test. Ce qui est à la fois bien et mal. C’est bien parce que ça évite de faire un nouveau test sur des animaux, lequel test ne serait pas fiable pour l’homme. C’est mal parce que l’évaluation de la carcinogénicité se fonde alors sur des données animales et n’est donc toujours pas fiable pour l’homme. La méthode des références croisées est considérée par les responsables de la règlementation comme une méthode alternative acceptée, alors que du point de vue scientifique elle peut être valable ou pas, selon les données de toxicité sur lesquelles elle se base.

Outre les accidents toxiques ou les effets secondaires révélés par la prise de médicaments, il est fort heureusement possible d’obtenir des données de toxicologie fiables pour l’homme par un grand nombre de méthodes. Voyons-en quelques-unes.

La science moderne et future

Cultiver des cellules humaines est devenu une activité bien maîtrisée. A ses débuts (première moitié du XXème siècle), cette méthode permettait d’obtenir une seule couche de cellules d’une durée de vie de quelques jours. Aujourd’hui, on cultive tous les types cellulaires humains, on peut développer des cultures en trois dimensions et des organoïdes capables de rester en vie pendant plusieurs mois. Les systèmes les plus sophistiqués sont réservés à la recherche biomédicale mais la toxicologie (surtout lorsqu’il s’agit de médicaments) peut bénéficier aussi de ces innovations.

Les tests sur cellules humaines vont du plus simple au plus complexe. A savoir tout d’abord que l’on peut se procurer des cellules humaines dans le commerce, sans aucun problème éthique, ou bien auprès de services hospitaliers avec le consentement du malade auquel ces cellules seraient de toutes façons extraites pour des motifs thérapeutiques, diagnostiques ou même esthétiques (ablation de tumeurs, biopsie, liposuccion, etc.).

Les cellules humaines utilisées en toxicologie peuvent être d’origine cancéreuse mais capables tout de même de développer des mécanismes normaux de défense ou de réparation de dégâts causés par la substance chimique objet du test. Ou bien ce peut être des cellules normales, ou bien encore des cellules souches (non embryonnaires, donc, toujours sans problème éthique).

Les progrès récents dans la recherche sur les cellules souches créent de nouvelles possibilités car ces cellules représentent une source quasi inépuisable et peuvent générer de multiples types cellulaires. Par exemple, des cellules souches prélevées sur de la peau humaine ont été utilisées pour générer des cellules ayant les propriétés des cellules hépatiques qui pourraient servir à évaluer la toxicité hépatique des médicaments (ALTEX Proceedings, Prague 2014, II-4b-347). Cette méthode pourrait être intéressante car les tests sur des animaux révèlent très mal la toxicité hépatique des médicaments pour l’homme et que cette toxicité est l’une des principales causes de retrait de médicaments du marché -après que de nombreuses victimes humaines aient révélé cet effet !

Un exemple de méthode simple pour identifier les métabolites produits par le foie consiste à tester la substance sur une préparation biochimique (donc, même pas besoin de cultiver des cellules) contenant les cytochromes P450, un ensemble d’enzymes hépatiques chargées, précisément, de métaboliser les substances chimiques. C’est le principe de la méthode Biomimiks , présentée comme un outil pour une meilleure évaluation des effets secondaires de médicaments mais qui pourrait également servir à tester n’importe quelle substance chimique. Cette méthode permet aussi d’étudier des interactions possibles entre différentes substances chimiques et serait donc intéressante pour évaluer les réactions d’un patient qui prend déjà plusieurs médicaments à une nouvelle molécule, par exemple.

Sur culture de cellules, les tests les plus simples sont ceux de cytotoxicité : on mesure à quelle dose une substance chimique tue un lot de cellules. C’est déjà une indication de toxicité aiguë. Plus la dose est faible, plus la substance est toxique. Ca ne renseigne pas sur le mode d’action de la substance mais ce test est nécessaire pour passer aux suivants : exposer des cellules à des doses non létales et voir quels mécanismes biologiques sont affectés.

Pour comprendre ces effets, il faut disposer de marqueurs au sein des cellules. Ce peut être des marqueurs fluorescents, des marqueurs qui montrent l’activité électrique des membranes cellulaires, etc. Ces marqueurs, ou encore la technique des gènes reporters (gènes dont les variations d’expression révèlent une activité particulière dans la cellule), existaient déjà au siècle dernier. C’est à l’orée de l’an 2000, avec la fin du séquençage du génome humain, que la toxicogénomique est apparue.

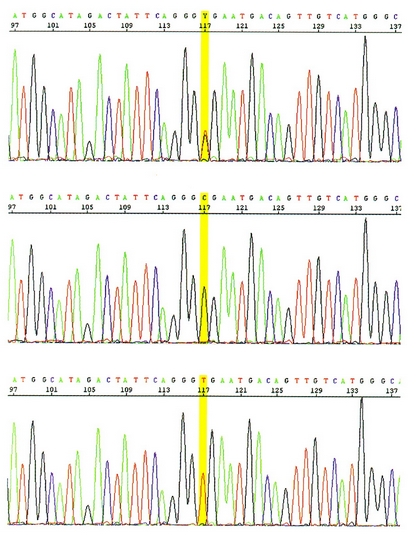

En 2004, pionnière en Europe, Antidote proposait de passer à la vitesse supérieure. Voyant dans la toxicogénomique une méthode d’avenir, nous en avons proposé une version simplifiée, bien plus rapide et peu coûteuse. Tous les détails dans le hors série de La Notice d’Antidote. Qu’est-ce que la toxicogénomique ? C’est une méthode qui tire parti à la fois de la maîtrise des cultures cellulaires et de la connaissance de plus en plus précise du rôle de chacun des plus de 20.000 gènes humains. Un peu plus d’un millier de ces gènes sont impliqués dans les réactions face à une substance chimique introduite dans le milieu de culture. Parmi ceux-ci, on peut en isoler un sous-ensemble de quelques dizaines impliqués dans des voies métaboliques dont la perturbation peut entraîner des maladies. La toxicogénomique consiste à exposer des cellules en culture à la substance chimique que l’on évalue, et à « mesurer » les perturbations induites dans les gènes impliqués dans ces voies métaboliques particulières. L’ « outil de mesure » s’appelle une « puce à ADN » ; nous n’entrerons pas ici dans les détails.

En 2004, nous cultivions séparément des cellules humaines de foie et neuronales. Exposer les cellules neuronales au liquide produit par les cellules du foie, elles-mêmes exposées à la substance chimique, nous avait permis de comprendre ce qui se passerait dans un organisme entier, où le foie transforme les substances qui lui arrivent par le sang en « métabolites » qui peuvent être plus toxiques encore que la substance d’origine. Les tests sur des animaux n’indiquent pas si les effets constatés sont causés par la substance ou par ses métabolites. Ils ne permettent pas d’élucider par quel mécanisme la substance provoque les effets observés. Cancer, par exemple. Mais suite à une mutation de l’ADN ? Suite au dérèglement du cycle cellulaire ? Suite à une perturbation des fonctions hormonales ? Tout cela requiert, en utilisant des animaux, des expériences complémentaires. Alors qu’un seul test de toxicogénomique peut apporter toutes ces réponses, le même test pouvant permettre aussi d’évaluer d’autres toxicités (neurologique, immunologique, etc.) et leurs mécanismes.

Dès 2004, nous appliquions déjà deux concepts qui allaient apparaître formellement dans la toxicologie règlementaire à partir de 2007 : le principe du criblage à haut débit et le principe des AOP. Basée sur un petit ensemble de gènes, la toxicogénomique peut servir au criblage à haut débit, c’est-à-dire au classement de dizaines de milliers de substances selon leur toxicité estimée de façon grossière en vue de tests plus précis. Grâce à la robotisation, cela peut se faire en peu de temps et à faible coût. Les substances à tester dans le cadre de REACH seraient donc une application évidente de cette approche. Pour les médicaments, quand il faut avoir une connaissance précise du mode d’action de la substance, la toxicogénomique peut aussi être utilisée avec davantage de gènes et plusieurs types cellulaires. Elle permettrait alors d’élucider des AOP. Grâce à cette connaissance,il pourrait être possible, selon les cas, de « corriger » les molécules chimiques, par exemple, en conservant la partie active et en modifiant la partie qui provoque la toxicité. La toxicogénomique est très utilisée, aussi bien en recherche qu’en toxicologie, comme en attestent des tonnes de publications la citant. Mais aucune méthode d’essai incluant des études de toxicogénomique n’a été proposée pour validation.

Bien des méthodes ont été développées depuis une décennie pour cultiver ensemble différents types de cellules ou pour faire circuler des substances d’un compartiment de culture à un autre, de façon à mimer le mieux possible le trajet et les transformations d’une substance à l’intérieur d’un corps humain. A titre d’exemple, nous vous avons parlé du système Quasi-Vivo développé par Meg Lewis (La Notice d’Antidote de septembre 2013), du mini-poumon développé par Samuel Constant (La Notice d’Antidote de décembre 2013), du système immunitaire dans un tube à essai mentionné par Margaret Clotworthy dans l’interview qu’elle nous accordait pour La Notice d’Antidote de septembre 2009.

Citons encore, parmi les publications les plus récentes, les « organes sur puce », des dispositifs microscopiques faits de compartiments contenant des cellules humaines, reliés entre eux par des canaux où circule un fluide permettant à la substance de circuler comme elle le ferait dans le corps humain (Nat Protoc, 2013, 8(11), 2135-57). Une vidéo expliquant ce système est disponible sur notre site. L’Institut national de la santé (NIH) états-unien a lancé le programme Organes sur puces, dans le but de créer des dispositifs miniaturisés qui représentent des unités fonctionnelles des dix systèmes humains majeurs : circulatoire, respiratoire, intertégumentaire, reproducteur, endocrinien, gastro-intestinal, nerveux, urinaire, musculo-squelettique et immunitaire. Cette nouvelle et unique plateforme in vitro pourrait contribuer à l’identification précoce de médicaments sûrs et efficaces et au rejet des médicaments toxiques plus tôt dans le processus de développement des médicaments (ALTEX Proceedings, Prague 2014, V-1-229).

De tels systèmes peuvent être utilisés pour évaluer des réactions systémiques, c’est-à-dire des réactions qui impliquent le corps entier. La toxicocinétique (ou pharmacocinétique, s’il s’agit d’un médicament) est l’étude du trajet de la substance dans le corps : combien de temps elle met à atteindre les différents tissus et organes (intestin, foie, circulation sanguine, organe cible, tissu graisseux, reins…), à quel moment elle agit, avant d’être éliminée. Des dispositifs comme les systèmes Hurel (ATLA, 2009, vol 37, suppl 1, pp 11-8) ou Quasi-Vivo peuvent répondre à ces questions si les différents compartiments cellulaires sont conçus pour cela. Autre système, la microdialyse (ATLA, 2009, vol 37, suppl 1, pp 57-9), permet de mesurer la concentration d’un médicament dans un organe donné chez un patient, afin d’améliorer la compréhension de la distribution du médicament dans l’organisme et de perfectionner la thérapie. Autre système encore, le microdosage, combiné à une technique de spectrométrie de masse, fournit une approche sûre pour obtenir les premières données de pharmacocinétique chez l’homme (ALTEX Proceedings, Prague 2014, VI-4-479).

La douleur ne fait pas partie des effets évalués par les tests de toxicologie requis par la règlementation. Dans l’interview qu’elle nous accordait pour La Notice d’Antidote de juin 2011, la cardiologue Anne Keogh déclarait : « des rats ne pourraient pas dire aux chercheurs qu’un médicament appelé terbogrel provoque des douleurs osseuses intolérables. Pour aussi efficace qu’ait pu être le terbogrel, cet effet secondaire était si intense chez l’homme que ce médicament a été abandonné. » Evaluer la douleur que pourrait provoquer un nouveau médicament est un problème complexe et nous voyons bien grâce à cet exemple que les tests sur des animaux n’aident pas à le résoudre. S’il n’est pas possible d’évaluer la douleur elle-même sur des cellules en culture, il serait possible de mesurer l’expression des gènes impliqués dans les processus qui provoquent la douleur. Beaucoup de douleurs ont pour origine un processus inflammatoire, par exemple. Or, évaluer par toxicogénomique l’activation de gènes impliqués dans l’inflammation est tout à fait possible.

On remplace ?

Les règlementations actuelles se trouvent dans une situation hybride. Elles n’utilisent pas encore les méthodes de criblage à haut débit mais elles introduisent progressivement des méthodes (dont certaines basées sur des AOP) pour remplacer certains tests effectués, jusqu’à présent, sur des animaux.

Les modèles de peau humaine reconstituée sont parmi les plus anciens. EpiDermTM, EPISKIN® et SkinEthicTM ont été introduits dans la règlementation pour l’évaluation de l’irritation cutanée, de la corrosion cutanée, de la phototoxicité (ALTEX Proceedings, Prague 2014, VI-5-933). Ils peuvent prédire la phototoxicité (réactions toxiques induites par la lumière -plus précisément par les rayons ultraviolets-) d’une substance chimique avec une fiabilité proche de 100% (ALTEX Proceedings, Prague 2014, II-4b-777). Un épiderme humain « immature » a été développé pour évaluer l’irritation cutanée par des produits d’hygiène pour bébés (ALTEX Proceedings, Prague 2014, II-10a-377).

Des modèles non encore validés pourraient évaluer la sensibilisation cutanée. La sécrétion d’interleukine-18 par des cellules de peau en culture a été identifiée comme une mesure utile pour déterminer le potentiel allergisant d’une substance. En utilisant le modèle de culture de peau humaine en trois dimensions EpiDermTM, des substances sensibilisantes ont été correctement identifiées dans 91% des cas, sans faux positifs (ALTEX Proceedings, Prague 2014, II-12-742).

Le cas des tests de sensibilisation cutanée est intéressant. Ils mesurent la capacité d’une substance à induire une réaction allergique suite à un contact avec la peau. Les tests « classiques » se faisaient sur le cobaye avant d’être remplacés par un test sur souris (essai de stimulation locale des ganglions lymphatiques -ELGL), considéré à présent comme la méthode de référence. Un AOP décrivant le processus menant à la dermatite de contact allergique a été adopté par l’OCDE le 4 février 2015 (ligne directrice 442D) :

– l’événement moléculaire initiateur est l’établissement d’une liaison covalente entre des substances chimiques électrophiles et les centres nucléophiles des protéines de la peau ;

– le deuxième événement clé se déroule dans les kératinocytes (un type de cellules de la peau) et comprend des réponses inflammatoires et des phénomènes d’expression génique ;

– le troisième événement clé est l’activation des cellules dendritiques, habituellement évaluée d’après l’expression de marqueurs de surface spécifiques de la cellule, les chimiokines et les cytokines ;

– le quatrième événement clé est la prolifération des lymphocytes T (cellules impliquées dans les réactions immunitaires) évaluée indirectement par l’ELGL.

La méthode KeratinosensTM a été mise au point pour évaluer le deuxième événement clé mais elle a été validée par comparaison avec l’ELGL, alors même que les autorités reconnaissent que cette méthode peut ne pas être fiable : « Au demeurant, dans l’évaluation des méthodes d’étude de la sensibilisation cutanée sans expérimentation animale, il convient de tenir compte du fait que l’ELGL et les autres méthodes d’expérimentation animale ne reflètent peut-être pas parfaitement la situation chez l’espèce d’intérêt, à savoir l’être humain. (…) Une étude complémentaire s’appuyant de préférence sur des données humaines fiables sera nécessaire pour déterminer de quelle façon les résultats de la méthode KeratinosensTM peuvent contribuer à l’évaluation de la puissance et à la sous-catégorisation des sensibilisants. »

C’est nous qui soulignons « s’appuyant de préférence sur des données humaines fiables ». Si des données humaines fiables existent, par quelle méthode ont-elles été obtenues et pourquoi ne pas considérer cette méthode comme la méthode de référence ?

La ligne directrice 429, qui concerne l’ELGL, comporte un tableau de 22 substances pouvant être utilisées comme références pour valider d’autres méthodes. Ce tableau compare les résultats obtenus pour l’évaluation de la sensibilisation cutanée par une méthode utilisant le cobaye, par l’ELGL et des observations sur l’homme. Pour 2 de ces substances, les données humaines ne sont pas disponibles. Sur 20 substances de référence, 4 (soit 20%) induisent des réactions différentes chez la souris (ELGL) et chez l’homme, 2 induisent des réactions différentes chez le cobaye et chez l’homme, 3 induisent des réactions différentes chez le cobaye et la souris. Alors… fiables pour l’homme, les tests sur des rongeurs ?

Cobayes malgré nous

Pour que plus aucun test de toxicologie ne soit fait sur des animaux, il suffirait que certains responsables politiques s’aperçoivent premièrement des dégâts causés à la santé humaine par l’utilisation de données animales, deuxièmement de la disponibilité et de la supériorité des méthodes sans animaux et que, à la suite de ces constatations, ils imposent une réforme de la loi qui supprimerait l’exigence de la validation des méthodes (surtout par référence aux méthodes animales !) et favoriserait tout simplement l’utilisation des méthodes les plus fiables. Il existe suffisamment de publications scientifiques pour déterminer, selon le « poids des preuves », quelles sont ces méthodes.

A noter que les tests sur des animaux n’évitent nullement les tests sur l’homme. Quand on propose de supprimer les premiers, on s’entend rétorquer par les personnes qui ne connaissent pas la réglementation : « et vous voudriez donc que les tests soient faits sur des humains ? » Que nous le voulions ou pas, les tests sont faits sur des humains. Pour tous les médicaments, c’est obligatoire. Au cours de ces essais sur l’homme, 9 médicaments sur 10 sont abandonnés alors qu’ils semblaient efficaces et non toxiques pour les animaux.

Qu’en est-il des substances non médicamenteuses ? La réalité est que la population entière est transformée en cohorte de cobayes. Nous sommes tous exposés à des milliers de substances chimiques. Chacun de nous, y compris les bébés qui viennent de naître, en a plusieurs centaines dans le sang. Comment sait-on quels sont les effets de ces substances ? Malheureusement, après constatation de la toxicité sur des individus humains. Les tests effectués sur des animaux n’avaient pas tiré la sonnette d’alarme. La question « faut-il tester sur des animaux pour éviter les tests sur l’homme ? » est mal posée. La réalité, c’est que les industriels font des tests sur des animaux parce que ces tests permettent d’obtenir le résultat souhaité (mais non, le maïs OGM n’est pas dangereux pour les rats ! puisqu’on vous le dit…), que les humains servent ensuite de cobayes et que la toxicité réelle des substances chimiques n’est reconnue qu’après étude d’un nombre important de victimes humaines par l’épidémiologie, les études cliniques ou la pharmacovigilance.

Remplacer les tests sur des animaux par des études sur des cellules humaines avec des méthodes modernes permettrait de recueillir des données toxicologiques pertinentes pour l’homme et, ainsi, éviterait d’exposer des êtres humains à des substances dangereuses pour nous.